您好,欢迎进入深圳市颖特新科技有限公司官方网站!

您好,欢迎进入深圳市颖特新科技有限公司官方网站!

存储市场冰火两重天,HBM价格暴涨5倍

实际上,自去年Q3以来,DRAM市场进入寒冬。今年以来时不时听到存储要触底反弹的声音,但目前市场仍未解冻。据TrendForce最新研究显示,由于DRAM供应商减产速度不及需求走弱速度,DRAM产品Q2均价季度跌幅扩大至13~18% 。

在DRAM的整体颓势之中,HBM却在逆势增长。据悉,2023年开年后三星、SK海力士两家存储大厂HBM订单快速增加,HBM3规格DRAM价格上涨超过5倍。

一边是DRAM整体跌幅仍在进一步扩大,另一边是HBM价格却暴涨5倍,冰火两重天。不禁要问,HBM为什么会这么重要?主要用在什么地方?HBM逆势增长的主要驱动原因是什么?

HBM:AI芯片的最佳搭档

按照不同应用场景,JEDEC(固态技术协会)将DRAM分为三个类型:标准DDR、移动DDR以及图形DDR。HBM属于最后一种,即图形DDR。

内存墙,指的是内存性能严重限制CPU性能发挥的现象。存储器与处理器性能差异正随时间发展逐渐扩大,当存储器访问速度跟不上处理器数据处理速度时,存储与运算之间便筑起了一道“内存墙”。而随着人工智能、高性能计算等应用市场兴起,数据量指数级增长,“内存墙”问题也愈发突出。

图形DDR中,先出现的是GDDR,它是为了设计高端显卡而特别设计的高性能DDR存储器,是打破“内存墙”的有效方案。随着深度学习等 AI 算法的发展,AI 服务器对计算能力和内存带宽的要求越来越高。GDDR 逐渐达到极限,每秒每增加1GB 的带宽所需要的电量剧增,NVIDIA 和 AMD 等厂商逐渐开始使用 HBM。

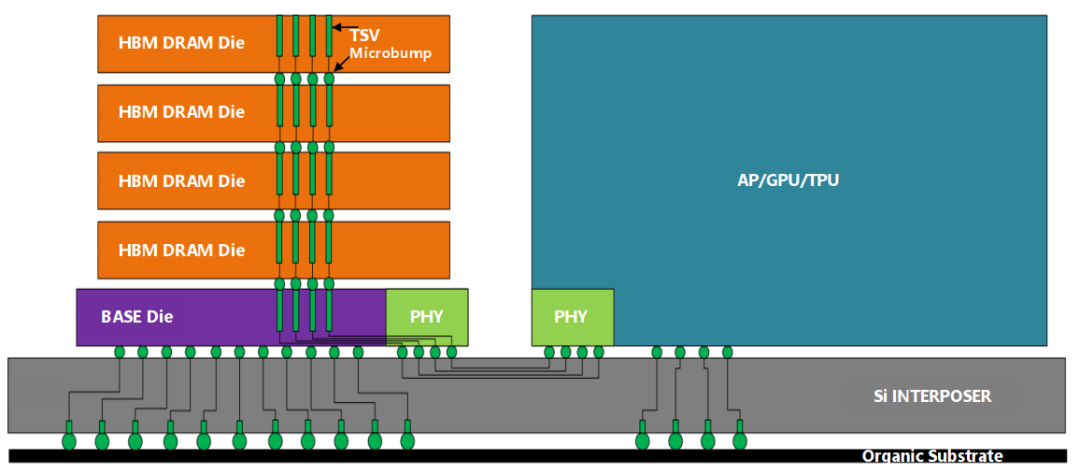

HBM(High Bandwidth Memory)即高带宽存储器,其通过使用先进的封装方法(如TSV硅通孔技术)垂直堆叠多个DRAM,并与GPU封装在一起。HBM通过系统级封装(SIP)和硅通孔(TSV)技术实现垂直堆叠,拥有多达1024个数据引脚,可显著提升数据传输速度,因此成为AI芯片中存储的主流技术方案。

HBM结构图

资料来源:美光官网

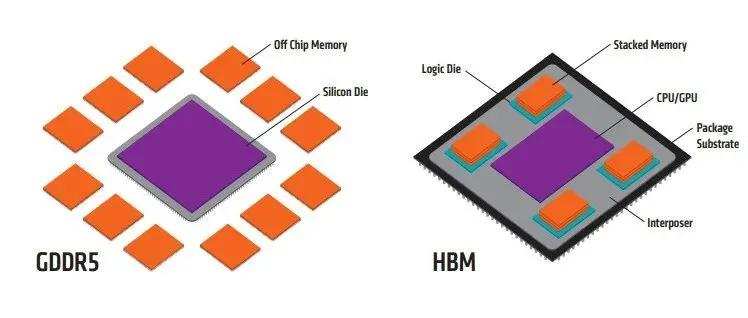

相较而言,GDDR独立封装在PCB上围绕在处理器的周围,而HBM则排布在硅中阶层上并和GPU封装在一起,面积缩小,离GPU更近,数据传输也更快。HBM之所以可以做到这样的布局,是因为采用了3D堆叠技术,其直接结果就是接口变得更宽。因此,与传统内存技术相比,HBM具有更高带宽、更多I/O数量、更低功耗、更小尺寸的特点。与 GDDR5 相比,在相同数量显存下,HBM产品大小仅仅是 GDDR5 的 6%,并且每瓦带宽是其 3 倍以上。

HBM与GDDR5对比

资料来源:AMD官网

在HBM技术加持之下,DRAM芯片从2D转变为3D,可以在很小的物理空间里实现高容量、高带宽、低延时与低功耗。自2014年首款硅通孔HBM产品问世至今,HBM技术已经发展至第四代,分别是:HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)。HBM朝着不断提高存储容量、带宽,减小功耗和封装尺寸方向不断升级,从最初的1GB存储容量和128GB/s 带宽的HBM1发展到目前的24GB存储容量和819GB/s带宽。

乘AI东风,HBM需求激增

今年 ChatGPT 引爆全球,AI 相关需求呈快速增长态势。据Bloomberg Intelligence报告显示,生成式 AI 市场规模有望爆发式增长,从 2022 年的 400 亿美元高速扩大至 2032 年的 1.3 万亿美元,十年间复合增速高达 42%。而 AI 的快速发展,对数据量和算力的需求也有大幅拉动,将拉动相关半导体需求的持续提升。

TrendForce 最新报告预计,2023年AI服务器出货量(含GPU、FPGA、ASIC等)预估在120万台,年增长率近38%。AI芯片出货量同步看涨,预计今年将增长50%。报告称,目前高端AI服务器GPU搭载HBM芯片已成主流,预计2023年全球HBM需求量将年增近六成,达到2.9亿GB,2024年将再增长30%。

作为高性能GPU的核心组件,根据Omdia 数据,2020 年全球 HBM 市场规模为 4.58 亿美元,预计 2025 年市场规模将达到 25 亿美元,年复合增长率高达 40.38%。

在ChatGPT等AI浪潮的推动下,高端AI芯片纷纷选择搭载HBM技术,推升了HBM存储需求。根据TrendForce统计,NVIDIA、AMD、Intel等高端AI芯片中大多选择搭载HBM。目前NVIDIA的A100及H100各搭载达80GB的HBM2e及HBM3,在其最新整合CPU及GPU的Grace Hopper芯片中,单颗芯片HBM搭载容量再提升20%,达96GB。AMD的MI300也搭配HBM3,其中,MI300A容量与前一代相同为128GB,更高端MI300X则达192GB,提升了50%。

DRAM原厂主导HBM市场,SK海力士称王

HBM市场目前由三大DRAM原厂占据,SK海力士占据过半份额。根据TrendForce统计,2022年三大原厂HBM市占率分别为SK海力士50%、三星约40%、美光约10%,预计2023年SK海力士将受益新世代HBM3产品的量产,其市占率有望提升至53%。

SK海力士是目前唯一量产HBM3的公司,并向英伟达大量供货,配置在英伟达高性能GPU H100之中,持续巩固其市场领先地位。今年4月SK海力士又推出24GB HBM3产品(HBM3E),容量再度提升且采用更薄的DRAM芯片垂直堆叠,实现了与16GB产品相同的高度,正被头部公司争相申请样片测试。据韩媒Korea Times报道,三星的HBM3产品预计23H2量产,届时将追赶SK海力士的市场。美光科技则进展相对较慢,于2020年7月宣布大规模量产HBM2E,HBM3作为其产品线仍在持续研发之中。

2021年的时候,HBM占整体DRAM市场只有不到1%。主要是因为HBM高昂的成本以及当时服务器市场中搭载相关AI运算卡的比重仍小于1%,且多数存储器仍使用GDDR5、GDDR6来支持其算力。

今年以来,AI的浪潮愈演愈烈。在ChatGPT带动的AIGC(生成式AI)的热潮下,大厂们纷纷开始推出自己的类ChatGPT的大模型。TrendForce预测,到2025年,全球如果等同于ChatGPT的超大型AIGC有5款,类似Midjourney的中型产品有25款,以及80款小型产品,在这个条件下,上述所需的运算资源至少包含145600~233700颗英伟达A100 GPU。作为高性能GPU的核心组件,HBM今后的存在感或许会越来越强。

最新HBM产品消息,BusinessKorea报道,包括英伟达、AMD、微软、亚马逊在内的全球科技巨擘,已依序向SK海力士要求HBM3E样品。申请样本是下单前的必要程序,目的是厘清存储器与客户的GPU、IC或云端系统是否兼容。据信,该公司正在为今年下半年准备 8Gbps HBM3E 产品样品,并计划在明年上半年实现量产。

上一篇:从台积电最新财报看半导体产业发展